Arquitecturas 2

Que es ps/2

El conector PS/2 o puerto PS/2 toma su nombre de la serie de computadoras IBM PersonalSystem/2 que es creada por IBM en 1987, y empleada para conectar teclados y ratones. Muchos de los adelantos presentados fueron inmediatamente adoptados por el mercado del PC, siendo este conector uno de los primeros.

En ambos casos es serial (bidireccional en el caso del teclado), y controlada por microcontroladores situados en la placa madre. No han sido diseñados para ser intercambiados en caliente, y el hecho de que al hacerlo no suela ocurrir nada es más debido a que los microcontroladores modernos son mucho más resistentes a cortocircuitos en sus líneas de entrada/salida.

Aunque idéntico eléctricamente al conector de teclado AT DIN 5 (con un sencillo adaptador puede usarse uno en otro), por su pequeño tamaño permite que en donde antes sólo entraba el conector de teclado lo hagan ahora el de teclado y ratón, liberando además el puerto RS-232 usado entonces mayoritariamente para los ratones, y que presentaba el inconveniente de compartir interrupciones con otro puerto serial (lo que imposibilitaba el conectar un ratón al COM1 y un módem al COM3, pues cada vez que se movía el ratón cortaba al módem la llamada)

A su vez, las interfaces de teclado y ratón PS/2, aunque eléctricamente similares, se diferencian en que en la interfaz de teclado se requiere en ambos lados un colector abierto para permitir la comunicación bidireccional. Las computadoras normales de sobremesa no son capaces de identificar al teclado y ratón si se intercambian las posiciones.

Un puerto paralelo es una interfaz entre un computador y un periférico, cuya principal característica es que los bits de datos viajan juntos, enviando un paquete de byte a la vez. Es decir, se implementa un cable o una vía física para cada bit de datos formando un bus. Mediante el puerto paralelo podemos controlar también periféricos como focos, motores entre otros dispositivos.

El cable paralelo es el conector físico entre el puerto paralelo y el dispositivo periférico. En un puerto paralelo habrá una serie de bits de control en vías aparte que irán en ambos sentidos por caminos distintos.

En contraposición al puerto paralelo está el puerto serie, que envía los datos bit a bit por el mismo hilo

serie y VGA

VGA es la abreviatura de Video Graphics Array. Un puerto VGA utiliza un conector de 15 pines, generalmente está situada en la parte posterior o lateral de una computadora. VGA es la interfaz estándar que sirve para conectar un monitor o proyector a los equipos.

El estándar VGA fue desarrollado originalmente por IBM en 1987 y fue la sustitución de las normas MDA, CGA y EGA. Para entender la necesidad e importancia, en esa época, de la tarjeta de vídeo VGA veamos un resumen de las normas usadas previamente:

- El estándar MDA o adaptador de pantalla monocromo permitía sólo texto monocromático y una resolución de 720/350 píxeles, era utilizado para aplicaciones no gráficas;

- Norma CGA o adaptador de gráficos en color soportaba texto con color pero con resolución de 320/200 píxeles;

- EGA estándar o Enhanced Graphics Adapter tenía 16 colores y podía servir gráficos con resolución de 640/350.

VGA permitió incrementar la resolución de pantalla de la época a 640×480 píxeles, con 256 colores disponibles y una paleta de colores de 262,144. Poco después, la resolución VGA subió a 800X600, convirtiéndose en la configuración de los sistemas operativos Windows hasta la década del 2000.

En la actualidad la norma VGA ha sido reemplazada por SVGA y en las computadoras modernas por DVI e incluso por HDMI que permite mejor resolución. Muchas computadoras todavía vienen con un puerto VGA, existen convertidores de señal a VGA en caso de necesitar una salida de ese tipo y el equipo no tenga uno.

Similar ocurre con los monitores y televisores modernos de pantalla plana LCD o LED, muchos de los cuales tienen un conector de entrada VGA disponible como una de los dos o tres entradas usadas para conectarse con una computadora.

Puerto de serie

El puerto serial, puerto serie o puerto de comunicación COM, es una interfaz de comunicaciones entre ordenadores y periféricos el cual envía y recibe información BIT por BIT, entre los puertos seriales se puede mencionar el puerto de los antiguos modelos de teclados y módems.

Un puerto serial posee un conector estándar y trabaja con un protocolo que permite la conexión de dispositivos al computador. Se denomina «serial» porque el puerto serie «serializa» los datos. Esto quiere decir que toma un byte de datos y transmite los 8 bits del byte de uno en uno.

Los puertos seriales utilizan un chip especial denominado UART (Universal Asynchronous Reciever/Transmitter). Este chip toma la salida paralela del bus del computador y lo convierte en forma serial, lo que permite la transmisión de los datos a través del puerto.

El conector externo para un puerto serial puede ser de 9 o de 25 pines.

firewire

La conectividad es un aspecto muy importante que siempre debemos de tener en cuenta a la hora de comprar un dispositivo electrónico “inteligente”. Del puerto de conexión depende en gran medida que podamos interactuar con este equipo a través de un ordenador o hacerlo compatible con determinados dispositivos. Casi todos conocemos muy bien que es un puerto USB, pero no todos conocen el Firewire, y lo cierto es que actualmente difícilmente lo encontraremos, pero merece la pena saber qué es y cómo funciona por si algún día nos encontramos uno y necesitamos utilizarlo.

Qué es el puerto Firewire

Lo primero que debemos saber es que su nombre oficial es puerto IEEE 1394 debido al protocolo estándar de comunicación que utiliza. Si un equipo tiene Firewire, lo verásidentificado de esta forma casi con total probabilidad.

El puerto Firewire es un tipo de conexión de entrada y salida para proporcionar comunicación a gran velocidad entre dispositivos multimedia. Funciona mediante la transferencia de datos en serie, al igual que un puerto USB y es utilizado principalmente para conectar cámaras digitales profesionales, impresoras y otros dispositivos en los que típicamente encontramos el puerto USB.

El principal motivo por el que no lo vemos con demasiada frecuencia es porque el uso del puerto USB está muchísimo más extendido en Europa, y es por ello que lo podremos ver con mayor frecuencia en el continente americano. Además, este puerto es utilizado principalmente por equipos de Apple, ya que fue el fabricante que lo inventó en 1995 y lo implementó en su gama de productos, tanto ordenadores personales como equipos profesionales.

Bus de datos

Muchas veces hemos hablado de la transmisión de Impulsos Eléctricos de un ordenador, de como éstos son interpretados como Datos por parte de un procesador, el cual los ordena, interpreta y da el sentido por el cual pueden pasar a ser considerados Información, pero para ello es necesario contar con un entorno, que es justamente el del Bus de Datos, concepto que analizaremos y describiremos a continuación.En lo que es la Arquitectura y el diseño de los ordenadores el Canal de Datos, también llamado como Bus de Datos, es un sistema en el cual tenemos una transferencia digitalentre los distintos componentes y dispositivos presentes en un equipo.

Está conformado por una gran cantidad de cables o circuitos que están "impresos" en los distintos dispositivos, con un diseño específico dado por el fabricante y para cada funcionalidad determinada, contando con Circuitos Integrados que a su vez incluyen Resistores, Capacitores y Condensadores, entre otros componentes que forman parte de un Sistema Electrónico.

Los primeros ordenadores contaban con una distribución de Buses de Datos con un diseño en paralelo, de forma que la comunicación de datos entre los distintos componentes del equipo se podría realizar mediante Bus de Cintas, que se distribuían en una impresión bastante particular.

En este diseño, cada elemento conductor tenía una función específica, con una función única, y por lo que solamente requería el diseño de un Puerto de Entrada para un bus específico, y otro con un Puerto de Salida, presente en cada conexión con los componentes.

Se podría hacer una analogía entonces del Bus de Datos con lo que es una carretera, en la que tendremos un tránsito de Impulsos Eléctricos que tienen una dirección unívoca en cada uno de estos caminos, siendo ordenado este tráfico hacia las acciones que giran en torno a la Unidad Central de Procesamiento.

Sumado a éste también tenemos el Bus de Direcciones, que se encarga de ubicar cada uno de los datos enviados y recibidos hacia un Sistema de Memoria que guarda un vínculo con las funciones del Procesador, mientras que por otro lado tenemos un Bus de Controlque tiene la misión de controlar los datos que son brindados hacia el equipo (es decir, los Impulsos Eléctricos transportados)

El diseño de Buses Paralelos hoy en día está siendo dejado de lado en el diseño de ordenadores por la llegada de Buses Seriales Universales (USB) que permite alcanzar una mayor velocidad de transferencia, un mejor rendimiento y además más funcionalidades.

Cable de datos IDE

Aunque las siglas IDE esconden varias acepciones, en general nos referimos a un tipo de conexión informática de transmisión de datos entre componentes del ordenador. Las siglas responden a las palabras inglesas Integrated Drive Electronics (IDE), y como hemos dicho, fueron un estandar de conexión hasta hace bien poco, siendo últimamente desplazado por el interfaz SATA (Serial ATA).

El interfaz IDE nació debido a una necesidad imperiosa de poder conectar componentes de distintos fabricantes en un mismo ordenador. Esto antes no era posible, pues cada marca vendía su producto completo y con componentes propios. Un disco duro de un IBM no serviría en un ordenador COMPAQ, y eso era una tara importante. El nombre original del IDE era ATA (AT Attachment, un interfaz creado por IBM para conectar los componentes de sus equipos), y con el tiempo el cable entrelazado creado por IBM acabó siendo de uso común, al darse cuenta los fabricantes que hacer componentes universales tenía grandes ventajas y ampliaba su círculo de clientes potenciales. ATA e IDE son pues términos sinónimos.

En principio se usaba para conectar discos duros, y más tarde lectores y grabadores de CD/DVD... etc, debido a su alta velocidad de transmisión de datos. Era muy raro usarlo para componentes externos.

La interfaz IDE se basaba en usar un cable plano y entrelazado (ver imagen) de conexión entre el componente y la unidad central o placa base, con 40 pins. Cada pin tenía una función asignada, siendo 15 bits de datos, los dos de los extremos servían para verificar que se había enchufado correctamente, y el resto para configurar diversos parámetros. El conector era un rectángulo plano en donde se insertaban los pins del disco duro por un extremo y de la placa en el otro, estando marcado con un código de colores cada lado para evitar confusiones y malas conexiones.

Algunos cables tenían 44 pins, siendo estos 4 adicionales para llevar la corriente al dispositivo, aunque solo se usaban en componentes muy pequeños que requerían poca energía. Otros tenían dos conectores, uno al principio para la placa base, otro en el medio para colocar un disco duro esclavo, y otro final para conectar al disco duro principal o maestro. Esto permitía a los ordenadores conectar más dispositivos de los permitidos inicialmente por la placa base, que solía traer una o dos conexiones para discos duros nada más.

Con el tiempo salieron más versiones, como la EIDE (enhanced IDE), que traía 80 pins, pero se mantuvo por comodidad el nombre de IDE para todas estas conexiones. En definitiva, hubo muchas versiones y mejoras desde su creación, pero siempre se intentó mantener la compatibilidad entre ellas.

Cable de datos sata

Serial ATA, S-ATA o SATA (Serial Advanced Technology Attachment) es una interfaz de bus de computadoras para la transferencia de datos entre la placa base y algunos dispositivos de almacenamiento, como la unidad de disco duro, lectora y grabadora de discos ópticos (unidad de disco óptico), unidad de estado sólido u otros dispositivos de altas prestaciones que están siendo todavía desarrollados. Serial ATA sustituye a Parallel-ATA, P-ATA principios del año 2001 se formó un grupo con el nombre de Serial ATA Working Group OG. Los miembros fundadores del grupo continuaron formando el Serial ATA II Working Group para seguir con el desarrollo de la siguiente generación de especificaciones para Serial ATA. La nueva organización, SATA-IO, toma las tareas de mantenimiento de las especificaciones, promoción y venta de Serial ATA. Además de crear una futura interfaz con especificaciones de velocidad que encabecen la tecnología de almacenamiento durante la siguiente década.

El cambio de Serial ATA II Working Group a una asociación industrial formal fue tomado por el Serial ATA II Steering Committee que encontró que un beneficio comercial mutuo les daría mayor ventaja a la hora de promover cualquier actividad necesaria para la adopción de Serial ATA. La SATA-IO se dedica a construir un mercado robusto y maduro para las ofertas de Serial ATA. Y, en su caso, seguirá actividades tales como: un programa de concienciación tecnológica y de logo, laboratorios de interoperabilidad y encuentros cara a cara.

La diferencia principal entre un grupo de trabajo y una asociación industrial formal es que la segunda es una entidad independiente legalmente. Así es posible tener un presupuesto más formalizado y es capaz de amparar actividades para el desarrollo de SATA. Los miembros de SATA-IO tienen la capacidad de influir o contribuir directamente al desarrollo de las especificaciones de SATA..A o también llamado IDE.

SATA proporciona mayores velocidades, mejor aprovechamiento cuando hay varias unidades, mayor longitud del cable de transmisión de datos y capacidad para conectar unidades al instante, es decir, insertar el dispositivo sin tener que apagar la computadora o que sufra un cortocircuito como con los viejos conectores molex.

Es una interfaz aceptada y estandarizada en las placas base de las computadoras personales (PC). La “Organización Internacional Serial ATA” (SATA-IO) es el grupo responsable de desarrollar, manejar y conducir la adopción de especificaciones estandarizadas de SATA. Los usuarios de la interfaz SATA se benefician de mejores velocidades, dispositivos de almacenamientos actualizables de manera más simple y configuración más sencilla. El objetivo de SATA-IO es conducir a la industria a la adopción de SATA definiendo, desarrollando y exponiendo las especificaciones estándar para la interfaz SATA.

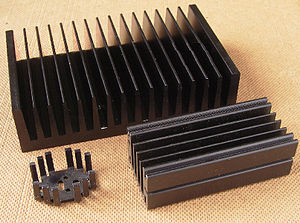

Un disipador es un instrumento que se utiliza para bajar la temperatura de algunos componentes electrónicos.

Su funcionamiento se basa en la ley cero de la termodinámicUn disipador de temperatura transfiere la energía por calor, del componente que refrigera, hacia el entorno, normalmente al aire. Para ello es necesaria una buena conducción térmica a través del mismo, por lo que se suelen fabricar de aluminio por su ligereza, pero también de cobre, cabe aclarar que el peso es importante ya que la tecnología avanza y por lo tanto se requieren disipadores más ligeros y con eficiencia suficiente para la transferencia de energía por calor al ambiente o entorno.

El diseño está construido con aluminio y otros metales (acero, etc.).

En los dispositivos electrónicos se suelen usar para evitar un aumento de la temperatura en algunos componentes. Por ejemplo, se emplea sobre transistores en circuitos de potencia para evitar que las altas temperaturas puedan llegar a quemarlos.

En las computadoras su uso es intensivo y prolongado, como por ejemplo en algunas tarjetas gráficas o en el microprocesadorpara disminuir las altas temperaturas, producto de la conmutación de los transistores en su interior. Sin embargo, en ocasiones las temperaturas en los componentes es demasiado elevada como para poder emplear disipadores de dimensiones razonables, llegando a ser necesarias otras formas de refrigeración como la refrigeración líquida.

También, se emplea en consolas de videojuegosa, transfiriendo el calor de la parte caliente que se desea disipar al aire. Este proceso se propicia aumentando la superficie de contacto con el aire, permitiendo una eliminación más rápida del calor excedente.

Disco duro

En informática, la unidad de disco duro o unidad de disco rígido (en inglés: hard disk drive, HDD) es el dispositivo de almacenamiento de datos que emplea un sistema de grabación magnética para almacenar archivos digitales. Se compone de uno o más platos o discos rígidos, unidos por un mismo eje que gira a gran velocidad dentro de una caja metálica sellada. Sobre cada plato, y en cada una de sus caras, se sitúa un cabezal de lectura/escritura que flota sobre una delgada lámina de aire generada por la rotación de los discos. Es memoria no volátil.

El primer disco duro fue inventado por IBM, en 1956. A lo largo de los años, han disminuido los precios de los discos duros, al mismo tiempo que han multiplicado su capacidad, siendo la principal opción de almacenamiento secundario para computadoras personales, desde su aparición en los años 1960.1 Los discos duros han mantenido su posición dominante gracias a los constantes incrementos en la densidad de grabación, que se ha mantenido a la par de las necesidades de almacenamiento secundario.1

Los tamaños también han variado mucho, desde los primeros discos IBM hasta los formatos estandarizados actualmente: 3,5 pulgadas los modelos para PC y servidores, y 2,5 pulgadas los modelos para dispositivos portátiles. Todos se comunican con la computadora a través del controlador de disco, empleando una interfaz estandarizada. Los más comunes hasta los años 2000 han sido IDE (también llamado ATA o PATA), SCSI (generalmente usado en servidores y estaciones de trabajo). Desde el 2000 en adelante ha ido masificándose el uso de los SATA. Existe además FC (empleado exclusivamente en servidores).

Para poder utilizar un disco duro, un sistema operativo debe aplicar un formato de bajo nivel que defina una o más particiones. La operación de formateo requiere el uso de una fracción del espacio disponible en el disco, que dependerá del sistema de archivos o formato empleado. Además, los fabricantes de discos duros, unidades de estado sólido y tarjetas flash miden la capacidad de los mismos usando prefijos del Sistema Internacional, que emplean múltiplos de potencias de 1000 según la normativa IEC e IEEE, en lugar de los prefijos binarios, que emplean múltiplos de potencias de 1024, y son los usados por sistemas operativos de Microsoft. Esto provoca que en algunos sistemas operativos sea representado como múltiplos 1024 o como 1000, y por tanto existan confusiones, por ejemplo un disco duro de 500 GB, en algunos sistemas operativos será representado como 465 GiB (es decir gibibytes; 1 GiB = 1024 MiB) y en otros como 500 GB.

Fuente de poder

Fuente de poder es un componente del computador que se encarga de transformar una corriente eléctrica alterna en una corriente eléctrica continua transmitiendo la corriente eléctrica imprescindible y necesaria a los ordenadores para el buen funcionamiento y protección de estos.

Son conocidas dos tipos de fuentes de poder: Fuente de Poder AT y Fuente de Poder ATX.

Fuente de poder AT

La fuente de poder AT sus siglas AT significan Advanced Tecnology traducido al español Tecnología Avanzada. La fuente de poder AT también es conocida por fuente de alimentación AT, fuente analógica, fuente de encendido mecánico, entre otros.

Características de la fuente de poder AT

La fuente de poder AT posee las siguientes características:

Es de encendido mecánico, tiene un interruptor que al oprimirse cambia de posición y este no vuelve a su estado inicial hasta no ser presionado nuevamente.

Algunas fuentes de poder cuenta con un conector de tres terminales para alimentar el monitor CRT desde la misma fuente.

Es una fuente ahorradora ya que no queda en “Stand by” o “Espera” porque al suprimir el botón se corta el abastecimiento de energía.

Es segura ya que al encenderse se interrumpe la electricidad dentro de los circuitos.

Este tipo de fuentes se integran desde equipos tan antiguos como microprocesador Intel 8026 hasta equipos procesadores Intel Pentium MMX.

Colores y cables de la fuente de energía AT

La fuente de poder AT tiene 3 tipos de conectores de salida:

Los conectores tipo Molex y tipo Berg son aquellos que se utilizan en periféricos que necesitan más consumo de energía, tales como: discos duros, unidades ópticas, disqueras, cada conector posee 4 líneas de alimentación. Los conectores tipos Molex y Berg son identificados con los siguientes colores: 1 línea de alimentación color rojo (5 Volts), 2 línea de alimentación color negro (tierra), 1 línea de alimentación color amarillo (12 Volts).

El conector tipo AT es aquel que interconecta la fuente AT a la placa madre, cuenta con 12 líneas de alimentación que se distinguen con los siguientes colores; 1 línea de alimentación color anaranjado (Power Good), 4 líneas de alimentación de color rojo (5 Volts), 1 línea de alimentación de color amarillo (12 Volts), 1 línea de alimentación de color azul (-12 Volts), 1 línea de alimentación de color blanco (-5 Volts) y 4 líneas de alimentación de color negro (tierra).

La correcta conexión de la fuente AT a la placa madre es a través de 6 líneas de alimentación, las cuales deben ir enchufadas de modo que los cables negros queden unidos en el centro.

Fuente de poder ATX

La fuente de poder ATX las siglas ATX significan Advanced Tecnology Extended. La fuente de poder ATX es la segunda generación de fuentes de poder, es la actual fuente de poder que sustituye a la fuente de poder AT. La fuente de poder ATX es conocida como fuente de alimentación ATX, fuente digital, fuente de encendido digital, entre otras denominaciones. La fuente de poder ATX fue creada por Intel en 1995 con el fin de optimizar los periféricos de entrada y salida y reducir el costo del sistema.

Características de la fuente de poder ATX

La fuente de poder ATX cuenta con las siguientes características:

Es de encendido digital, tiene un pulsador en lugar de un interruptor.

Algunas fuentes de poder cuentan con un interruptor mecánico trasero para evitar el estado de reposo durante el cual consume cantidades de energía eléctricas mínimas e innecesaria.

El apagado de la fuente de poder ATX puede ser operada desde el software.

Este tipo de fuentes se integran desde equipos con microprocesador Intel Premium MMX hasta equipos con los microprocesadores más modernos.

Colores y cables de la fuente de energía ATX

La fuente de poder ATX contiene 6 tipos de conectores de salida:

La fuente de poder ATX cuenta con los mismos conectores de tipo Molex y Berg de la fuente de poder AT.

El conector SATA /SATA 2 es aquel conector usado en dispositivos de discos duros cuenta con 15 líneas de alimentación y son identificadas de la siguiente manera; 3 líneas de alimentación V33 (3.3 Volts), 3 líneas de alimentación V5 (5 Volts), 3 líneas de alimentación V12 (12 Volts), 4 líneas de alimentación GND (tierra), 1 línea de reserved (reservado).

El conector ATX es aquel que interconecta la fuente ATX a la placa madre, posee 24 líneas de alimentación conformadas por los siguientes colores; 4 líneas de alimentación de color naranja (3.3 Volts), 8 líneas de alimentación de color de negro (tierra), 6 líneas de alimentación de color rojo (5 Volts), 1 línea de alimentación de color gris (Power Good), 1 línea de alimentación de color púrpura (5 VSB), 2 líneas de alimentación de color amarillo (12 Volts), 1 línea de alimentación de color azul (-12 Volts), 1 línea de alimentación de color verde (Power On), 1 línea de alimentación de color blanco (-5 Volts).

El conector para procesador de 4 terminales es aquel que alimenta a los procesadores modernos, cuenta con 2 líneas de alimentación de color negro (tierra) y 2 líneas de alimentación de color amarillo (12 Volts).

El conectador PCIe, conectador de 6 y 8 terminales, es destinado para alimentar la tarjeta de video tipo PCIe, tiene 4 líneas de alimentación de color negro (tierra) y 4 líneas de color amarillo (12 Volts).

La fuente de poder ATX permite una única forma de conexión evitando errores como sucedía en la fuente de energía AT.

Funcionamiento de las fuentes de poder AT y ATX

El proceso de convertir la corriente alterna en corriente continua a través de las fuentes de poder AT y ATX comprende 4 etapas:

Transformación: El voltaje de la línea eléctrica comercial se reduce de 127 Volts a 12 Volts o 5 Volts por el uso del elemento electrónico denominado bobinas reductoras.

Rectificación: Se transforma el voltaje de la corriente alterna en voltaje de la corriente continua dejando pasar únicamente los valores positivos de la onda a través del elemento electrónico llamado diodos.

Filtrado: Suaviza el voltaje y calidad a la corriente continua por medio de elementos electrónicos nombrados capacitadores.

Estabilización: El voltaje suavizado se le da forma de lineal por el uso del elemento electrónico distinguido como circuito integrado. En esta etapa se suministra la energía necesaria a los ordenadores.

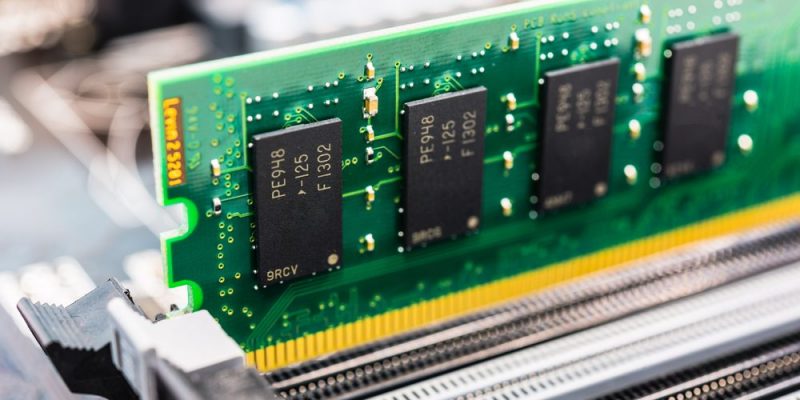

En informática, la memoria RAM (acrónimo de Random Access Memory, o Memoria de Acceso Aleatorio) es un tipo de memoria operativa de los computadores y sistemas informáticos, adonde va a ejecutarse la mayor parte del software: el propio sistema operativo, el software de aplicación y otros programas semejantes.

Su nombre proviene del hecho de que puede grabarse o recuperarse información de ella sin necesidad de un orden secuencial (como sí ocurre en la memoria ROM o Read-Only Memory, Memoria de Sólo Lectura), sino que puede accederse al RAM de la manera más rápida posible, con un tiempo de espera igual para cualquier posición de memoria.

La memoria RAM además es una forma de memoria temporal, que al apagar o reiniciar el sistema vuelve a estar en blanco. Esto considerando que al inicio del sistema los módulos básicos de funcionamiento (como el POST o el BIOS), inscritos a menudo en ROM, hacen un chequeo de la memoria RAM para asegurarse de que esté operativa y se pueda volcar en ella el software necesario para iniciar el sistema.

Este tipo de memoria no siempre se encuentra soldada a la placa madre (en las consolas de videojuegos, por ejemplo, sí lo está), sino que descansa en tarjetas de circuitos impresos retirables y sustituibles en la misma, conocidos como Módulos de RAM. Cada módulo posee un número de chips de memoria y una capacidad específica, medida actualmente en megabytes (1024 kilobytes) o gigabytes (1024 megabytes).

Hoy en día existen dos tipos de memoria RAM contrapuestos:

- SRAM. Acrónimo de Static Random Access Memory (o sea: Memoria Estática de Acceso Aleatorio), designa un tipo de memoria que se sustenta en semiconductores y capaz de mantener los datos sin necesidad de circuitos de refrescamiento, siempre y cuando se mantenga alimentada. De este tipo son las memorias NVRAM (Non-volatile Random Access Memory, o RAM no volátil) y MRAM (Magnetoresistive Random Access Memory, o RAM magnética).

- DRAM. Acrónimo de Dynamic Random Access Memory (o sea: Memoria Dinámica de Acceso Aleatorio), basa su tecnología en condensadores, que al perder carga progresivamente, requieren de un circuido de refresco que revisa su carga y la repone. Fue inventada a finales de 1960 y es el tipo más empleado actualmente, pues permite crear módulos de enorme densidad de posiciones y alta velocidad de recuperación. De este tipo son las memorias DRAM Asincrónica y SDRAM (Synchronous Dynamic Random Access Memory, o DRAM sincrónica)

Memoria rum

La memoria ROM es el medio de almacenamiento de programas o datos que permiten el buen funcionamiento de los ordenadores o dispositivos electrónicos a través de la lectura de la información sin que pueda ser destruida o reprogramable. El significado de memoria ROM es “Read Only Memory” traducido al español “Memoria de solo lectura.”

La memoria ROM es conocida como memoria no volátil ya que la información contenida en ella no es borrable al apagar el dispositivo electrónico.

La memoria ROM se encuentra instalada en la tarjeta madre “motherboard” lugar donde se encuentra la información básica del equipo, llamada “BIOS.”

La memoria ROM más antigua es la MROM almacena datos indestructibles y para la actualización del software o datos es necesario reemplazar el chip lo cual no puede ser realizado por cualquier persona sino por un experto o el mismo fabricante, con los avances tecnológicos pocos programas se almacenan en la memoria ROM ya que la mayoría de ellos se encuentran en las nuevas memorias ROM; Memoria Erasable Programable Read Only Memory (EPROM) es una memoria reprogramable y borrable a través de fuertes rayos ultravioletas, y la Memoria Electrically Erasable Programmable Read-Only Memory (FLASH EEPROM) puede ser reprogramable, borrable y permite alterar el contenido a través de señales eléctricas.

Dese el año 2007 es muy difícil hallar dispositivos con la memoria ROM ya que los equipos reprogramables son más flexibles y económicos.

Para qué sirve la memoria ROM

La memoria ROM es de suma importancia para el buen funcionamiento de los ordenadores y dispositivos electrónicos ya que al ser encendidos la memoria ROM permite el arranque del programa inicial que dará lugar a la iniciación de todo el sistema.

La memoria ROM sirve para almacenar programas firmware, es decir, almacenar programas de sistema operativo, intérpretes de lenguajes, programas de control (encender el equipo); programar tablas de información (tablas de uso númericos); y otros programas que no necesitan ser modificados o actualizados constantemente.

Memoria ROM y memoria RAM

La información contenida en la memoria ROM no es borrable al apagar el ordenador ni con el corte de la energía eléctrica, es por ello que es llamada memoria no volátil, mientras que la información contenida en la memoria RAM o memoria volátil, es borrable y puede perderse en caso de que el utilizador no grabe la información en el ordenador, por ejemplo: cuando escribimos en Word se debe ir guardando la información.

La memoria RAM es más rápida para la lectura que la memoria ROM es por ello que normalmente la información contenida en la memoria ROM se transfiere a la memoria RAM.

La memoria RAM es de acceso aleatorio ya que la información permanece grabada en el aparato electrónico y es posible su rápido acce

Placa base o tarjeta madre

La placa base, también conocida como tarjeta madre, placa madre o placa principal (motherboard o mainboard en inglés), es una tarjeta de circuito impreso a la que se conectan los componentes que constituyen la computadora.

Es una parte fundamental para montar cualquier computadora personal de escritorio o portátil o algún dispositivo. Tiene instalados una serie de circuitos integrados, entre los que se encuentra el circuito integrado auxiliar (chipset), que sirve como centro de conexión entre el microprocesador (CPU), la memoria de acceso aleatorio (RAM), las ranuras de expansión y otros dispositivos.

Va instalada dentro de una carcasa o gabinete que por lo general está hecha de chapa y tiene un panel para conectar dispositivos externos y muchos conectores internos y zócalos para instalar componentes internos.

La placa base, además incluye un firmware llamado BIOS, que le permite realizar las funcionalidades básicas, como pruebas de los dispositivos, vídeo y manejo del teclado, reconocimiento de dispositivos y carga del sistema operativo.

Procesador

El procesador es el que se refiere a los diferentes tipos de artículos de sistemas informativos que forma parte de un microprocesador que es parte de un CPU o micro que es el cerebro de la computadora y de todos los procesos informativos desde los más sencillos hasta los más complejos.

El procesador de una computadora es el dispositivo de hardware que puede tener diversas propiedad, la unidad central de procesamiento o CPU, conocido como ‘’ cerebro’’ del sistema.

El hardware suele ser un chip de distintos tipos, formando múltiples microprocesadores en conexión, un microprocesador típico se compone de registros, unidad de control, unidad aritmética- lógica, entre otras.

Las partes internas de un procesador son los núcleos, cache, controladores de memoria, tarjeta gráfica y otros elementos.

El núcleo es un procesador en en reducción de un objeto de dimensiones reducidas que forma las partes de varias conexiones y les permite trabajar con más de una aplicación.

El caché es una memoria de la cámara que almacena el acceso con frecuencia y que poseen los ordenadores del sistema más importante en el interior de una computadora que está dividido por varios elementos, como la memoria principal que se utiliza con más frecuencia.

La memoria caché es la más cercana al micro ya que se encuentra en su interior y se utiliza para mejorar la rapidez del acceso de la memoria que se encuentra organizada en varios niveles mucho más lento y rápido que el anterior.

El controlador de memoria es un circuito digital que se encarga de hacer los trámites del flujo de datos entre el procesador y la memoria.

Tarjeta gráfica es la tarjeta de defunción para una computadora, encargada de someter una sustancia a un proceso de elaboración de datos.

Ranura PCI

En informática, Peripheral Component Interconnect o PCI (en español: Interconexión de Componentes Periféricos), es un busestándar de computadoras para conectar dispositivos periféricos directamente a la placa base. Estos dispositivos pueden ser circuitos integrados ajustados en esta (los llamados dispositivos planares en la especificación PCI) o tarjetas de expansión que se ajustan en conectores. Es común en computadoras personales, donde ha desplazado al ISA como bus estándar, pero también se emplea en otro tipo de computadoras.

En diferencia de los buses ISA, el bus PCI permite configuración dinámica de un dispositivo periférico. En el tiempo de arranque del sistema, las tarjetas PCI y el BIOS interactúan y negocian los recursos solicitados por la tarjeta PCI. Esto permite asignación de las IRQ y direcciones del puerto por medio de un proceso dinámico diferente del bus ISA, donde las IRQ tienen que ser configuradas manualmente usando jumpers externos. Las últimas revisiones de ISA y el bus MCA de IBM ya incorporaron tecnologías que automatizaban todo el proceso de configuración de las tarjetas, pero el bus PCI demostró una mayor eficacia en tecnología plug and play. Aparte de esto, el bus PCI proporciona una descripción detallada de todos los dispositivos PCI conectados a través del espacio de configuración PCI.

La especificación PCI cubre el tamaño físico del bus, características eléctricas, cronómetro del bus y sus protocolos. El “Grupo de Interés Especial de PCI” (PCI Special Interest Group) comercializa copias de la especificación.

Ranura IDE

La interfaz ATA, P-ATA o PATA, originalmente conocida como IDE, es un estándar de interfaces para la conexión de dispositivos de almacenamiento masivo de datos y unidades de discos ópticos que utiliza el estándar derivado de ATA y el estándar ATAPI.

La primera versión de la interfaz ATA, fue conocida como IDE y desarrollada por Western Digital, con la colaboración de Control Data Corporation (encargada de la parte del disco duro) y Compaq Computer (donde se instalaron los primeros discos).

En un primer momento, las controladoras ATA sólo se integraban en la placa madre de equipos de marca como IBM, Dell o Commodore. Su versión más extendida eran las tarjetas multi E/S, que agrupaban las controladoras ATA y disquetera, así como los puertos RS-232 y el puerto paralelo, y solo modelos de gama alta incorporaban zócalos y conectores SIMM para cachear el disco. Dicha integración de dispositivos trajo consigo que un solo chip fuera capaz de desempeñar todo el trabajo.

Junto a la aparición del bus PCI, las controladoras casi siempre están incluidas en la placa base, inicialmente como un chip, para después pasar a formar parte del chipset.

Ranura SATA

Serial ATA, S-ATA o SATA (Serial Advanced Technology Attachment) es una interfaz de bus de computadoras para la transferencia de datos entre la placa base y algunos dispositivos de almacenamiento, como la unidad de disco duro, lectora y grabadora de discos ópticos (unidad de disco óptico), unidad de estado sólido u otros dispositivos de altas prestaciones que están siendo todavía desarrollados. Serial ATA sustituye a Parallel-ATA, P-ATA o también llamado IDE.

SATA proporciona mayores velocidades, mejor aprovechamiento cuando hay varias unidades, mayor longitud del cable de transmisión de datos y capacidad para conectar unidades al instante, es decir, insertar el dispositivo sin tener que apagar la computadora o que sufra un cortocircuito como con los viejos conectores molex.

Es una interfaz aceptada y estandarizada en las placas base de las computadoras personales (PC). La “Organización Internacional Serial ATA” (SATA-IO) es el grupo responsable de desarrollar, manejar y conducir la adopción de especificaciones estandarizadas de SATA. Los usuarios de la interfaz SATA se benefician de mejores velocidades, dispositivos de almacenamientos actualizables de manera más simple y configuración más sencilla. El objetivo de SATA-IO es conducir a la industria a la adopción de SATA definiendo, desarrollando y exponiendo las especificaciones estándar para la interfaz SATA.

A principios del año 2001 se formó un grupo con el nombre de Serial ATA Working Group OG. Los miembros fundadores del grupo continuaron formando el Serial ATA II Working Group para seguir con el desarrollo de la siguiente generación de especificaciones para Serial ATA. La nueva organización, SATA-IO, toma las tareas de mantenimiento de las especificaciones, promoción y venta de Serial ATA. Además de crear una futura interfaz con especificaciones de velocidad que encabecen la tecnología de almacenamiento durante la siguiente década.

El cambio de Serial ATA II Working Group a una asociación industrial formal fue tomado por el Serial ATA II Steering Committee que encontró que un beneficio comercial mutuo les daría mayor ventaja a la hora de promover cualquier actividad necesaria para la adopción de Serial ATA. La SATA-IO se dedica a construir un mercado robusto y maduro para las ofertas de Serial ATA. Y, en su caso, seguirá actividades tales como: un programa de concienciación tecnológica y de logo, laboratorios de interoperabilidad y encuentros cara a cara.

La diferencia principal entre un grupo de trabajo y una asociación industrial formal es que la segunda es una entidad independiente legalmente. Así es posible tener un presupuesto más formalizado y es capaz de amparar actividades para el desarrollo de SATA. Los miembros de SATA-IO tienen la capacidad de influir o contribuir directamente al desarrollo de las especificaciones de SATA

Tarjeta de expansión

La tarjeta de expansión es un tipo de dispositivo con diversos circuitos integrados (chips) y controladores, que insertada en su correspondiente ranura de expansión sirve para expandir las capacidades de la computadora a la que se inserta.

Las tarjetas de expansión más comunes sirven para añadir memoria, controladoras de unidad de disco, controladoras de vídeo, puertos serie o paralelo y dispositivo de módem interno.

La tarjeta de expansión permite dotar a la computadora de algún elemento adicional.1

Las tarjetas suelen ser de tipo Peripheral Component Interconnect (PCI), PCI-Express o Accelerated Graphics Port(AGP). No se fabrican las placas de tipo Industry Standard Architecture (ISA).

Gracias los avances en la tecnología Universal Serial Bus (USB) y a la integración de audio, video o red en la placa base, las placas de expansión ahora son menos imprescindibles para tener una computadora completamente funcional.

Tarjeta de red

La tarjeta de red, también conocida como placa de red, adaptador de red, adaptador LAN, Interfaz de red física,1 o sus términos en inglés Network Interface Card o Network interface controller (NIC), cuya traducción literal del inglés es «tarjeta de interfaz de red» (TIR), es un componente de hardware que conecta una computadora a una red informática y que posibilita compartir recursos (como archivos, discos duros enteros, impresoras e internet) entre dos o más computadoras, es decir, en una red de computadoras.

Las primeras tarjetas de interfaz de red se implementaban comúnmente en tarjetas de expansión que se conectaban en un bus de la computadora. El bajo costo y la ubicuidad del estándar Ethernet hizo posible que la mayoría de las computadoras modernas tengan una interfaz de red integrada en la placa base. Las placas base de servidor más nuevas pueden incluso tener interfaces de red duales incorporadas.

Las capacidades de Ethernet están ahora integradas en el chipset de la placa base o implementadas a través de un chip Ethernet dedicado de bajo costo, conectado a través del bus PCI (o el nuevo PCI Express), así que no se requiere una tarjeta de red por separado a menos que se necesiten interfaces adicionales o se utilice otro tipo de red.

Las modernas Tarjetas de red ofrecen funciones avanzadas como interfaz de interrupción y DMA para los procesadores host, soporte para múltiples colas de recepción y transmisión, particionamiento en múltiples interfaces lógicas y procesamiento de tráfico de red en controlador, como el motor de descarga TCP.

La NIC pueden utilizar una o más de las siguientes técnicas para indicar la disponibilidad de paquetes a transferir:

- Polling, donde la CPU examina el estado del periférico bajo el control del programa.

- IRQ-E/S controlada, donde el periférico alerta a la CPU de que está listo para transferir datos.

Además, los NIC pueden utilizar una o más de las siguientes técnicas para transferir datos de paquetes:

- Entrada/salida programada, donde la CPU mueve los datos hacia o desde la NIC a la memoria.

- DMA, donde algún otro dispositivo que no sea la CPU asume el control del bus de sistema para mover datos hacia o desde la NIC a la memoria. Esto elimina la carga de la CPU, pero requiere más lógica en la tarjeta.

Además, un búfer de paquetes en la NIC puede no ser necesario y puede reducir la latencia. Existen dos tipos de DMA:

- DMA de terceros, en el que un controlador DMA distinto del NIC realiza transferencias y,

- Bus mastering, donde el propio NIC realiza transferencias.

Una tarjeta de red Ethernet normalmente tiene un socket 8P8C donde está conectado el cable de red. Las NICs más antiguas también proporcionaban conexiones BNC, o AUI. Algunos LEDsinforman al usuario si la red está activa y si se produce o no transmisión de datos. Las tarjetas de red Ethernet suelen soportar Ethernet de 10 Mbit/s, 100 Mbits/s y 1000 Mbits/s. Tales tarjetas son designadas como "10/100/1000", lo que significa que pueden soportar una tasa de transferencia máxima nocional de 10, 100 o 1000 Mbit/s. También están disponibles NIC de 10 Gbits/s 23

Tarjeta de sonido

Una tarjeta de sonido o placa de sonido es una tarjeta de expansión para computadoras que permite la salida de audio controlada por un programa informático llamado controlador (driver)

El uso típico de las tarjetas de sonido consiste en hacer, mediante un programa que actúa de mezclador, que las aplicaciones multimedia del componente de audio suenen y puedan ser gestionadas. Estas aplicaciones incluyen composición de audio y en conjunción con la tarjeta de videoconferencia también puede hacerse una edición de vídeo, presentaciones multimedia y entretenimiento (videojuegos). Algunos equipos (como computadoras personales) tienen la tarjeta ya integrada a la placa base, mientras que otros requieren tarjetas de expansión. También hay equipos que por su uso (como por ejemplo servidores) no requieren de dicha función.

Las tarjetas de sonido profesionales son habitualmente conocidas como "interfaces de audio",1 y a veces tienen la forma de unidades externas montables en rack que usan USB, FireWire o una interfaz óptica, para ofrecer suficiente velocidad de datos. En estos productos el énfasis está, en general, en tener múltiples conectores de entrada y salida, soporte de hardware directo para múltiples canales de sonido de entrada y salida, así como fidelidad y frecuencias de muestreo más altos en comparación con la típica tarjeta de sonido para el gran público. En este sentido, su papel y su propósito es más parecido al de una grabadora de datos multicanal y procesador/mezclador en tiempo real, funciones que solo son posibles hasta cierto punto con las típicas tarjetas de sonido para el consumidor medio.

Tarjeta de vídeo

La tarjeta de vídeo es un dispositivo electrónico que se encarga de regular y determinar la forma en cómo se mostraran las imágenes y texto que se observa en el monitor de la computadora. Son las que envían señal a nuestro monitor, televisor o proyector. La calidad de la tarjeta de video en una computadora influye sobre todo a la hora de jugar, editar vídeo o 3D.

La tarjeta de vídeo se encarga de traducir la información que se procesa en la computadora y mostrarla de manera que se pueda entender por el usuario común, a este dispositivo también se le conoce como controlador de vídeo, adaptador de vídeo, acelerador de vídeo o acelerador gráfico, en la actualidad existen muchas marcas y modelos de tarjetas de vídeo y la gran mayoría están destinadas para usuarios que requieren mucha capacidad gráfica para trabajar, por ejemplo los diseñadores gráficos o los vídeo jugadores.

Los componentes electrónicos que conforman una tarjeta de vídeo son:

Puerto VGA o estándar: Es el conector donde se instala el cable de la computadora que envía la señal de salida al monitor.

Puerto DVI: (Digital Video Interface) es un conector de salida para monitores digitales planos.

Puerto HDMI: (High Definition Multimedia Interface) es un conector de salida cuya interfaz multimedia de alta calidad se puede utilizar para conectar cualquier dispositivo que soporte esta tecnología de audio y video digital.

Puerto TV: Algunas de las tarjetas de video que hay en el mercado disponen de este componente para que se pueda ver televisión, pero se necesita de un chip que convierta la señal de audio digital en análoga compatible con la TV para poder lograrlo.

Memoria: Las tarjetas de vídeo cuentan con su propia memoria en la cual se almacena la información para posteriormente mostrarla, entre más memoria tenga una tarjeta de vídeo mayor cantidad de datos se podrá procesar y mejor calidad se mostrara en el monitor, la mayoría de las tarjetas utilizan memoria de tipo SDRAM, no confundir con memoria RAM, (Synchronous Dinamic Random Access Memory) o DDR SDRAM (Double Data Rate), actualmente se pueden encontrar tarjetas de video de 512mb, 1Gb y hasta más de memoria, las motherboardque ya traen incorporada tarjeta de vídeo por lo regular tienen de 64mb a 128mb de memoria.

Chip de video. Este prácticamente es el CPU de la tarjeta de vídeo y se le conoce con el nombre de GPU (Graphics Processing Unit) y es el encargado de generar los cálculos necesarios para mostrar una imagen lo que ahorra tiempo y energía al microprocesador de la computadora.

Tarjeta USB

La memoria USB (Universal Serial Bus), denominada también lápiz de memoria, dedo, lápiz USB, memoria externa, pen drive, memocápsula, mnemocápsula, memorín , "pendrive" o "llave maya" este último nombre solo es utilizado en Costa Rica, lo cual ha abierto múltiples debates en centros educativos entre alumnos y profesores de como debe ser llamado.

Es un tipo de dispositivo de almacenamiento de datos que utiliza circuitos de estado sólido para guardar datos e información.

Primera generación

Las empresas Trek Technology e IBM comenzaron a vender las primeras memocápsulas en el año 2000. Trek vendió un modelo bajo el nombre comercial de Thumbdrive e IBM vendió las primeras unidades en Norteamérica bajo la marca DiskOnKey, desarrolladas y fabricadas por la empresa israelí M-Systems en capacidades de 8 MB, 16 MB, 32 MB y 64 MB. Estos fueron promocionados como los «verdaderos reemplazos del disquete», y su diseño continuó hasta los 256 MB. Los modelos anteriores de este dispositivo utilizaban baterías, en vez de la alimentación de la PC.2

Segunda generación

Dentro de esta generación de dispositivos existe conectividad con la norma USB 2.0. Sin embargo, no usan en su totalidad la tasa de transferencia de 480 Megabit/s que soporta la especificación USB 2.0 Hi-Speed debido a las limitaciones técnicas de las memorias sólidas basadas en NAND. Los dispositivos más rápidos de esta generación usan un controlador de doble canal, aunque todavía están muy lejos de la tasa de transferencia posible de un disco duro de la actual generación, o el máximo rendimiento de alta velocidad USB.

Las velocidades de transferencia de archivos varían considerablemente. Se afirma que las unidades rápidas típicas pueden leer a velocidades de hasta 480 Megabit/s y escribir a cerca de la mitad de esa velocidad. Esto es aproximadamente 20 veces más rápido que en los dispositivos USB 1.1, que poseen una velocidad máxima de 24 Megabit/s.

Tercera generación

La norma USB 3.0 ofrece tasas de cambio de datos mejoradas enormemente en comparación con su predecesor, además de compatibilidad con los puertos USB 2.0. La norma USB 3.0 fue anunciada a finales de 2009, pero los dispositivos de consumo no estuvieron disponibles hasta principios de 2010. La interfaz USB 3.0 dispone las tasas de transferencia de hasta 4,8 Gbit/s, en comparación con los 480 Mbit/s de USB 2.0. A pesar de que la interfaz USB 3.0 permite velocidades de datos muy altas de transferencia, a partir de 2011 la mayoría de las unidades USB 3.0 Flash no utilizan toda la velocidad de la interfaz USB 3.0 debido a las limitaciones de sus controladores de memoria, aunque algunos controladores de canal de memoria llegan al mercado para resolver este problema. Algunas de estas memorias almacenan hasta 256 GB de memoria (lo cual es 1024 veces mayor al diseño inicial de M-Systems). También hay dispositivos, que aparte de su función habitual, poseen una memocápsula como aditamento incluido, como algunos ratones ópticos inalámbricos o memocápsulas con ranuras para reconocer otros tipos de almacenes (microSD, m2, etc.).

En agosto de 2010, Imation anunció el lanzamiento al mercado de la nueva línea de memocápsulas de seguridad Flash Drive Defender F200, con capacidades de 1 GiB, 2 GiB, 4 GiB, 8 GiB, 16 GiB y 32 GiB. Estas unidades de almacenamiento cuentan con un sensor biométrico ergonómico basado en un dispositivo que corrobora las coincidencias de las huellas dactilares de identificación, antes de permitir el acceso a la información.

Unidad de DVD

El DVD es un tipo de disco óptico para almacenamiento de datos.La sigla DVD2 corresponde a Digital Versatile Disc3 (Disco Versátil Digital), de modo que coinciden los acrónimos en español e inglés. En sus inicios, la “V” intermedia hacía referencia a video (Digital Video Disc o Disco de Video Digital), debido a su desarrollo como reemplazo del formato VHS para la distribución de vídeo a los hogares.

El estándar del DVD surgió en 1995 Consorcio (DVD Consortium).

La unidad de DVD es el dispositivo que hace referencia a la multitud de maneras en las que se almacenan los datos: DVD-ROM(dispositivo de lectura únicamente), DVD-R y DVD+R DVD-RW y DVD+RW (permiten grabar y luego borrar). También difieren en la capacidad de almacenamiento de cada uno de los tipos.

A comienzo de los años 1990, se estaban desarrollando dos estándares de almacenamiento óptico de alta densidad:

el multimedia compact disc (MMCD), apoyado por Philips y Sony;

el super density (SD), apoyado por Toshiba, Time Warner, Panasonic, Hitachi, Mitsubishi Electric, Pioneer, Thomson y JVC.

Philips y Sony se unieron, y acordaron con Toshiba adoptar el SD, pero con una modificación: la adopción del EFM Plus de Philips, creado por Kees Immink, que a pesar de ser un 6% menos eficiente que el sistema de codificación de Toshiba (de ahí que la capacidad sea de 4,7 GB en lugar de los 5 GB del SD original), cuenta con la gran ventaja de que EFM Plus posee gran resistencia a los daños físicos en el disco, como arañazos o huellas. El resultado fue la creación del Consorcio del DVD, fundado por las compañías anteriores, y la especificación de la versión 1.5 del DVD, anunciada en 1995 y finalizada en septiembre de 1996.1 En mayo de 1997, el Consorcio (DVD Consortium) fue reemplazado por el Foro DVD (DVD Forum) con los siguientes miembros:

Hitachi, Ltd.

Panasonic Corp

Mitsubishi Electric Corporation

Pioneer Electronic Corporation

Royal Philips Electronics N.V.

Sony Corporation

Thomson

Time Warner Inc.

Toshiba Corporation

Victor Company of Japan, Ltd. (JVC)

El Foro DVD creó los estándares oficiales:

DVD-ROM

DVD-R

DVD-RW

DVD-RAM

DVD+RW Alliance creó otros estándares (para evitar pagar la licencia al Foro):

DVD+R

DVD+RW

Dado que los discos DVD+R/RW no forman parte de los estándares oficiales, no muestran el logotipo oficial «DVD». En lugar de ello, llevan el logotipo «RW» incluso aunque sean discos que solamente puedan grabarse una vez, lo que ha suscitado cierta polémica en algunos sectores que lo consideran publicidad engañosa, además de confundir a los usuarios.

¿Que es un ventilador?

Un disipador/ventilador es un elemento físico, destinado a eliminar el exceso de calor de cualquier componente de un ordenador como la cpu o la tarjeta gráfica.

Su funcionamiento se basa en la segunda ley de la termodinámica, transfiriendo el calor de la parte caliente que se desea disipar al aire. Este proceso se propicia aumentando la superficie de contacto con el aire permitiendo una eliminación más rápida del calor excedenteDisipadores sin ventiladores de uso común en chipset y tarjetas gráficas de bajo consumo y generación de calor.

Vídeo

El video o vídeo es la tecnología de grabación, procesamiento, almacenamiento, transmisión de imágenes y reconstrucción por medios electrónicos digitales o analógicos de una secuencia de imágenes que representan escenas en movimiento. Etimológicamente, la palabra video proviene del verbo latino video, vides, videre, que se traduce como el verbo 'ver'. Se suele aplicar este término a la señal de vídeo y muchas veces se usa la denominación «el video» o «la video» a modo de abreviatura del nombre completo de la misma.

La tecnología de video fue desarrollada por primera vez para los sistemas de televisión, pero ha derivado en muchos formatos para permitir la grabación de video de los consumidores y que además pueda ser visto a través de Internet.

En algunos países se llama así también a una grabación de imágenes y sonido en cinta magnética o en disco óptico, aunque con la aparición de estos últimos dicho término se identifica generalmente con las grabaciones anteriores en cinta magnética, del tipo VHS, Betamax. Muchos videos se cuelgan en sitios web, como por ejemplo YouTube, que contiene diferentes tipos de reproducciones.

Inicialmente la señal de video está formada por un número de líneas agrupadas en varios cuadros y estos a la vez divididos en dos campos portan la información de luz y color de la imagen. El número de líneas, de cuadros y la forma de portar la información del color depende del estándar de televisión concreto. La amplitud de la señal de video es de 1Vpp (1 voltio de pico a pico) estando la parte de la señal que porta la información de la imagen por encima de 0V y la de sincronismos por debajo el nivel de 0V. La parte positiva puede llegar hasta 0,7V para el nivel de blanco, correspondiendo a 0V el negro y los sincronismos son pulsos que llegan hasta -0,3V. En la actualidad hay multitud de estándares diferentes, especialmente en el ámbito informático.

Chipset

Se trata de un componente esencial que se encuentra alojado en la motherboard de nuestra PC, pero puede que no conozcamos por completo cómo funciona el chipset de una computadora y cuál es la importancia de este pequeño componente en el funcionamiento del equipo.

Es por ello que en este artículo vamos a conocer todo lo necesario sobre este importante componente de la PC, incluyendo cuál es su función dentro de la computadora y los diferentes tipos de chipset que existen en el mercado actual, con lo cual conseguiremos, además de aprender un poco más acerca de nuestra PC, tener una idea más clara de lo que sucede en el caso que nuestro equipo falle.

Básicamente, Chipset es el nombre que se le da al conjunto de chips (o circuitos integrados) utilizado en la placa madre y cuya función es realizar diversas funciones de hardware, como control de los Bus (PCI, AGP y el antiguo ISA), control y acceso a la memoria, control de la interfaz I/O y USB, Timer, control de las señales de interrupción IRQ y DMA, entre otras.En pocas palabras, para hacerlo más comprensible para la mayoría de los usuarios, el chipset ocuparía el lugar de corazón de la computadora, ya que su función principal es la de recoger información y enviándola a la parte correspondiente para que la ejecución de la tarea solicitada sea realizada satisfactoriamente.

Módem

Un módem es un dispositivo que convierte las señales digitales en analógicas (modulación) y viceversa (desmodulación),2 y permite así la comunicación entre computadoras a través de la línea telefónica o del cablemódem. Sirve para enviar la señal moduladora mediante otra señal llamada portadora.

Se han usado módems desde la década de 1960, debido a que la transmisión directa de las señales electrónicas inteligibles, a largas distancias, no es eficiente; por ejemplo, para transmitir señales de audio por el aire se requerirían antenas de gran tamaño (del orden de cientos de metros) para su correcta recepción. Es habitual encontrar en muchos módems de red conmutada la facilidad de respuesta y marcación automática, que les permiten conectarse cuando reciben una llamada de la RTPC (Red Telefónica Pública Conmutada) y proceder a la marcación de cualquier número previamente grabado por el usuario. Gracias a estas funciones se pueden realizar automáticamente todas las operaciones de establecimiento de la comunicación.

Historia

Los servicios por cable de noticias en la década de 1920 utilizaban dispositivos multiplex que satisfacían la definición de un módem.3 Sin embargo, la función de módem era incidental a la función de multiplexación, por lo que generalmente no se incluyen en la historia de los módems.

Los módems surgieron de la necesidad de conectar teletipos a través de líneas telefónicas normales en lugar de en las líneas arrendadas más caras que anteriormente se habían utilizado para los teletipos basados en bucles de corriente y los telégrafos automatizados. En 1941, los Aliados desarrollaron un sistema de encriptado de voz llamado SIGSALY que usaba un vocoder para digitalizar el habla, luego encriptaba el habla con un teclado de una única vez y codificaba los datos digitales como tonos utilizando el cambio de frecuencia.

La producción generalizada de módems en Estados Unidos comenzó en 1958 (el año en que se usó por primera vez la palabra «modem»4) como un dispositivo parte del sistema de defensa aérea SAGE, conectando terminales en varias bases aéreas, en los lugares en que se situaban los radares y en los centros de mando y control con los centros directores del SAGE que se encontraban dispersos por Estados Unidos y Canadá. Los Bell Labs de AT&T describieron los módems SAGE como conformes a su entonces recientemente publicado estándar de conjunto de datos Bell 101. Mientras funcionaban en líneas telefónicas dedicadas, los dispositivos en cada extremo no eran diferentes de los módem comerciales de Bell 101, modems de 110 baudios.

Los Data-Phones 201A y 201B eran módems síncronos que utilizaban el cifrado de cambio de fase de dos bits por baudio (PSK). El 201A operaba medio dúplex a 2000 bit/s en las líneas telefónicas normales, mientras que el 201B proporcionaba un servicio dúplex completo de 2400 bit/s en líneas alquiladas de cuatro hilos, siendo los canales de envío y recepción ejecutados en su propio conjunto de dos hilos.

AT&T también introdujo en 1962 el famoso estándar de conjunto de datos Bell 103A.56 Proporcionaba un servicio dúplex completo a 300 bit/s en las líneas telefónicas normales. Se usó la modulación por desplazamiento de fase, con el originador de la llamada transmitiendo a 1070 o 1270 Hz y el módem que respondía transmitiendo a 2025 o 2225 Hz. El 103A2, fácilmente disponible, dio un impulso importante al uso de terminales remotos de baja velocidad como el Teletype Model 33 ASR y KSR, y el IBM 2741. AT&T redujo los costos de módem al introducir los modems 113D de solo origen y el 113B/C de solo respuesta.

Acoplador acústico

Durante muchos años, el sistema Bell (AT&T) mantuvo un monopolio en el uso de sus líneas telefónicas y de los dispositivos que podían estar conectados a ellas. Sin embargo, en la decisión fundamental de 1968 de la FCC sobre Carterfone (Carterfone Decision), la FCC concluyó que los dispositivos electrónicos podían conectarse al sistema telefónico siempre y cuando usaran un acoplador acústico. Dado que la mayoría de los teléfonos eran suministrados por Western Electric y, que por lo tanto tenían un diseño estándar, los acopladores acústicos fueron relativamente fáciles de construir. Los módems de 300 bit/s compatibles con Bell 103A acoplados acústicamente fueron comunes durante los años 1970. Los modelos más conocidos eran el Novation CAT y el Anderson-Jacobson, el último derivado de un proyecto interno en el Stanford Research Institute (ahora SRI International). Una opción aún más económica era el módem Pennywhistle, diseñado para ser construido con piezas de chatarra electrónica y de excedentes de tiendas.

En diciembre de 1972, Vadic lanzó el VA3400, notable para la operación de dúplex completo a 1200 bit/s a través de la red telefónica. Al igual que el 103A, utilizaba diferentes bandas de frecuencia para transmitir y recibir. En noviembre de 1976, AT&T presentó el módem 212A para competir con Vadic. Era similar en diseño, pero usaba el conjunto de frecuencias más bajas para la transmisión. También se podría usar el 212A con un módem 103A a 300 bit/s. Según Vadic, el cambio en las asignaciones de frecuencia hizo que el 212 fuese intencionalmente incompatible con el acoplamiento acústico, bloqueando así a muchos posibles fabricantes de módems. En 1977, Vadic respondió con el módem triple VA3467, un módem solo de respuesta vendido a operadores de centros de cómputo que admitían el modo de 1200 bit/s de Vadic, el modo 212A de AT&T y la operación 103A.

Bios

En el terreno de los PC compatibles IBM, el sistema básico de entrada-salida o BIOS (del inglés Basic Input/Output System) es un estándar de facto que define la interfaz de firmware para computadoras IBM PC compatibles.1 También es conocido como BIOS del sistema, ROM BIOS2 y BIOS de PC. El nombre se originó en 1975, en el BIOS usado por el sistema operativo CP/M.34

El firmware del BIOS es instalado dentro de la computadora personal (PC), y es el primer programa que se ejecuta cuando se enciende la computadora.

El propósito fundamental del BIOS es iniciar y probar el hardware del sistema y cargar un gestor de arranque o un sistema operativodesde un dispositivo de almacenamiento de datos. Además, el BIOS provee una capa de abstracción para el hardware, por ejemplo, que consiste en una vía para que los programas de aplicaciones y los sistemas operativos interactúen con el teclado, el monitor y otros dispositivos de entrada/salida. Las variaciones que ocurren en el hardware del sistema quedan ocultos por el BIOS, ya que los programas usan servicios de BIOS en lugar de acceder directamente al hardware. Los sistemas operativos modernos ignoran la capa de abstracción provista por el BIOS y acceden al hardware directamente.

El BIOS del PC/XT de IBM original no tenía interfaz interactiva con el usuario. Los mensajes de error eran mostrados en la pantalla, o codificados por medio de una serie de sonidos. Las opciones en la PC y el XT se establecían por medio de interruptores y jumpersen la placa base y en las placas de los periféricos. Las modernas computadoras compatibles Wintel proveen una rutina de configuración, accesible al iniciar el sistema mediante una secuencia de teclas específica. El usuario puede configurar las opciones del sistema usando el teclado y el monitor.

El software del BIOS es almacenado en un circuito integrado de memoria ROM no volátil en la placa base. Está específicamente diseñado para trabajar con cada modelo de computadora en particular, interconectando los diversos dispositivos que componen el conjunto de chips complementarios del sistema. En computadoras modernas, el BIOS está almacenado en una memoria flash, por lo que su contenido puede ser reescrito sin retirar el circuito integrado de la placa base. Esto permite que el BIOS sea fácil de actualizar para agregar nuevas características o corregir errores, pero puede hacer que la computadora sea vulnerable a los rootkit de BIOS.

El MS-DOS (PC DOS) fue el sistema operativo de PC dominante desde principios de la década de 1980 hasta mediados de la década de 1990. Dependía de los servicios del BIOS para las funciones de disco, teclado y visualización de textos. Windows NT, Linux y otros sistemas operativos de modo protegido en general no lo usan después de cargarse en memoria.

La tecnología de BIOS está en un proceso de transición hacia la interfaz de firmware extensible unificada (UEFI) desde el año 2010.5

Unidad de CD-ROM

Un CD-ROM1 (sigla del inglés Compact Disc Read-Only Memory), es un disco compacto con el que utilizan rayos láser para leer información en formato digital. El CD-ROM estándar fue establecido en 1985 por Sony y Philips.2 Pertenece a un conjunto de libros de colores conocido como Rainbow Books, que contiene las especificaciones técnicas para todos los formatos de discos compactos.

Algunas unidades leen CD-ROM y graban sobre los discos compactos de una sola grabada (CD-RW). Estas unidades se llaman quemadores, ya que funcionan con un láser que «quema» la superficie del disco para grabar la información.

Actualmente, aunque aún se utilizan, están empezando a caer en desuso desde que empezaron a ser sustituidos por unidades de DVD. Esto se debe principalmente a la mayor capacidad de almacenamiento de información, ya que un DVD-ROM supera en capacidad a un CD-ROM

Unidad de CD RW

El disco compacto regrabable, conocido por las siglas CD-RW (del inglés Compact Disc - ReWritable, originalmente R y W se usaban como los atributos del CD, que significan "read" y "write", lectura y escritura) es un tipo soporte digital en disco óptico utilizado para almacenar cualquier tipo de información.

Este tipo de CD puede ser grabado múltiples veces, ya que permite que los datos almacenados sean borrados.

En 1996, fue desarrollado conjuntamente por las empresas Sony y Philips; comenzó a comercializarse en 1997.

Tecnologías como el DVD han desplazado en parte esta forma de almacenamiento, aunque su uso sigue vigente.

En el disco CD-RW la capa que contiene la información está formada por una aleación cristalina de plata, indio, antimonio y telurio que presenta una interesante cualidad: si se calienta hasta cierta temperatura, cuando se enfría deviene cristalino, pero si al calentarse se alcanza una temperatura aún más elevada, cuando se enfría queda con estructura amorfa. La superficie cristalina permite que la luz se refleje bien en la zona reflectante mientras que las zonas con estructura amorfa absorben la luz. Por lo cual el CD-RW utiliza tres tipos de luz:

- Láser de escritura: usado para escribir. Calienta pequeñas zonas de la superficie para que el material se torne amorfo.

- Láser de borrado: usado para borrar. Tiene una intensidad menor que el de escritura con lo que se consigue el estado cristalino.

- Láser de lectura: usado para leer. Tiene menor intensidad que el de borrado. Se refleja en zonas cristalinas y se dispersa en las amorfas.

En los principios, la capacidad de un CD-RW fue de 650 MB; actualmente la capacidad es la misma que la de un CD-R, 700 MB.

Floppy

El sistema de almacenamiento de información conocido como disco Floppy es aquel que se caracteriza por su material flexible. Está compuesto a grandes rasgos por un disco donde se guarda la información y por un revestimiento negro cuadrado. Este sistema permite que la información pueda ser leída en un soporte seguro llamado disquetera. Su tamaño externo puede variar y ha habido en la historia tres tipos diferentes de disco Floppy.

Inventado por la empresa IBM, el disco Floppy ha conocido tres momentos: en 1969 se creaba el disco de 8 pulgadas, mientras que en 1976 se avanzaba hacia un modelo de 5 ¼ pulgadas y en 1983 se desarrollaba el modelo más pequeño, el de 3 ½ pulgadas. Este último modelo ha sido el que ha alcanzado mayor popularidad debido a su durabilidad y a su seguridad. Sin embargo, hoy en día su utilización se ha vuelto casi nula al lado del CD, que contiene mucho más espacio y es más práctico para usar.

DISIPADOR DE CALOR

Un disipador de calor (o disipador térmico) es un objeto que absorbe el calor. Los disipadores de calor se utilizan para una amplia gama de aplicaciones (tales como el diseño LED) cuanto más eficiente sea la disipación del calor más larga será la duración del producto. Los disipadores de calor están hechos de metal o de aleación, que normalmente incluye una combinación de aluminio y cobre.

Los Disipadores de calor también puede consistir en una o más superficies planas para asegurar un buen contacto térmico con los componentes que deben ser enfriados, y una matriz de peine o aleta como salientes para aumentar la superficie de contacto con el aire, y por lo tanto la tasa de disipación de calor.

La especificación de rendimiento para cualquier disipador de calor sería la resistencia térmica o la sensibilidad térmica, que se expresa típicamente en C ° / W como el aumento de la temperatura por vatio de calor. Al comparar las calificaciones, la resistencia térmica es una especificación nominal. Los principales factores que afectan a la resistencia térmica o la sensibilidad térmica incluyen mayor flujo de aire (aerodinámica), aire a presión o agua de refrigeración, método de montaje, y temperaturas ambiente. Con frecuencia, en las hojas de datos de los disipadores de calor, la resistencia térmica se presenta como una curva de rendimiento.

Para aumentar la transferencia térmica entre el componente y el disipador de calor, un adhesivo térmico (también conocida como grasa térmica) se puede añadir a la base del disipador de calor.

El tratamiento superficial puede ser de aluminio anodizado de color plateado.

El tratamiento superficial puede ser de aluminio anodizado de color plateado.

Lector óptico

Los lectores ópticos de marcas son sistemas que aceptan información escrita a mano y la transforman en datos binarios inteligibles por el ordenador, central. El usuario se limita a marcar con su lápiz ciertas áreas preestablecidas del documento que representan posibles opciones o preguntas.

Estos documentos pueden ser leídos posteriormente, a gran velocidad, por un ordenador con un lector óptico de marcas. Este detecta las zonas preestablecidas que están marcadas. Esta forma de introducir datos en la ordenador es útil, por ejemplo, para corregir exámenes de tipo test, escrutar quinielas, valorar encuestas, etc.

Una variante sencilla de este sistema la constituye el método de reconocimiento de marcas. En este caso el dispositivo de lectura puede reconocer cuándo ciertas áreas se han ennegrecido con un lápiz u otro instrumento de escritura.

Entre los documentos sometidos a esta forma de lectura se encuentran los cupones de las quinielas, los formularios para la lectura de los contadores de gas y luz, y los cuestionarios con respuesta de elección múltiple. Los métodos de OCR y de reconocimiento de marcas tienen la ventaja de que se pueden emplear para leer los datos directamente de los documentos originales, pero son lentos y sensibles a los errores, en comparación con otros métodos.

BATERÍA

Una batería eléctrica, acumulador eléctrico o simplemente pila, batería o acumulador, es un dispositivo que consiste en una o más celdas electroquímicas que pueden convertir la energía química almacenada en corriente eléctrica. Cada celda consta de un electrodopositivo, o ánodo, un electrodo negativo, o cátodo, y electrolitos que permiten que los iones se muevan entre los electrodos, permitiendo que la corriente fluya fuera de la batería para llevar a cabo su función, alimentar un circuito eléctrico.

Las baterías se presentan en muchas formas y tamaños, desde las celdas en miniatura que se utilizan en audífonos y relojes de pulsera, a los bancos de baterías del tamaño de las habitaciones que proporcionan energía de reserva a las centrales telefónicas y ordenadores de centros de datos.